Blog

Blog

Segundo Mauro, Greco e Grimaldi (2015), provavelmente a teoria mais popular nas definições sobre Big Data é a que fala sobre as suas características.

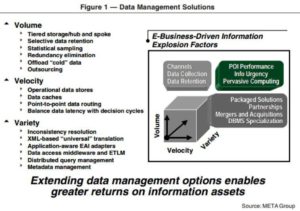

Em 2001, em um relatório da META Group (atual Gartner), Doug Laney fez uma previsão sobre como os negócios que dependem da informática iriam ser modificados, tendo por base as mudanças na forma de captura, processamento, armazenamento, recuperação e, dentre outros, apresentação dos dados.

Em seu relatório ele definiu o que iria mudar nos dados corporativos e deixa claro que os negócios, a partir de um dado momento, passariam a depender do entendimento de um novo e muito maior volume, velocidade e variedade de dados no seu dia a dia, vide figura 1.

Apesar do relatório não ter citado o termo Big Data explicitamente, tal ideia foi incutida nas suas definições e ficou conhecida como os 3 V’s do Big Data, acabando por tornar-se onipresente. Por exemplo, a TechAmerica Foundation define o termo da seguinte forma:

Big Data é um termo que descreve grandes volumes de alta velocidade, complexidade e variabilidade de dados que exigem técnicas e tecnologias avançadas para a captura, armazenamento, distribuição, gerenciamento e análise da informação. (TechAmerica Foundation’s Federal Big Data Commission, 2012, tradução nossa)

Abaixo, uma descrição sobre o que vem a ser volume, velocidade e variedade no Big Data:

Volume refere-se à quantidade exorbitante de dados que são produzidos atualmente, tendo em vista que além dos dados dos sistemas transacionais, lidamos com outra infinidade de dados que são gerados pelos objetos na Internet das Coisas, como por exemplo sensores e câmeras e os gerados pelos smartphones, tablets e computadores de mesa nas mídias sociais.

Velocidade diz respeito à rapidez com que os dados são coletados, armazenados e analisados. A proliferação de dispositivos digitais levou a criação de um número vasto de dados que necessitam de análises em tempo real, para haver um planejamento baseado em evidências.

Tal característica é um divisor de águas quando se fala em análises que tem por objetivo o aprimoramento de produtos, serviços e processos para tomada de decisões, tendo em vista que os dados perdem valor em decorrência do tempo, como explica Rosângela Marquesone:

[…]imagine, por exemplo, que um cliente receba recomendações de um produto em um e-commerce somente uma semana após ele ter realizado uma compra. Embora tal recomendação ainda possa gerar um efeito positivo, é muito provável que o impacto teria sido superior, caso essa tivesse sido realizada no momento da compra.[…] Uma empresa que entende isso muito bem é a Amazon, que adota mecanismos de precificação dinâmica, ela chega a atualizar os valores dos seus produtos a cada 10 minutos, de acordo com a análise da demanda em tempo real de seus suprimentos. (MARQUESONE, 2017,p.15)

Por fim, variedade, que significa a heterogeneidade das estruturas de um conjunto de dados.

Esse grande nível de variedade alavancou o surgimento de novas tecnologias de análise e armazenamento de dados, não somente como uma solução que fosse complementar aos bancos de dados relacionais [1], mas também como uma forma de fomentar negócios corporativos com soluções que atendam às necessidades específicas de aplicações em Big Data.

Alguns autores estendem tal compreensão e abordam outras características do Big Data como valor, complexidade, variabilidade e veracidade.

Segundo J. Dijcks (2012), a dimensão do Big Data correspondente ao valor seria o desafio de identificar quais dados são valiosos, tendo em vista que o valor econômico de diferentes tipos de dados varia significativamente.

A SAS [2] introduz a complexidade e a variabilidade como características do Big Data, a primeira fala sobre o desafio de conectar, combinar, limpar e transformar dados recebidos de diferentes fontes, a segunda fala sobre a variação nas taxas de fluxo desses dados.

Por último, a veracidade, que foi introduzida pela IBM [3], e que representa a falta de confiabilidade presente em algumas fontes de dados.

Dessa forma, podemos concluir que Big Data é um termo “novo”, utilizado para denominar uma prática antiga, que já vem sendo implementada há vários anos pelas empresas.

Sendo assim, apreender os seus conceitos é um exercício interessante para entender melhor o porquê do surgimento de algumas dinâmicas e demandas do mundo atual, principalmente se formos nos debruçar sobre o assunto da privacidade e proteção de dados pessoais, tema que está ligado, de forma intrínseca, a toda a cadeia de funcionamento dessa ferramenta.

Notas:

[1] O banco de dados relacional é o modelo tradicional usado pelas empresas, neste modelo os dados são armazenados em formato de tabelas, para que isso aconteça eles devem ter uma estrutura pré-definida, ou seja, antes de armazenar a informação, é necessário que a mesma tenha uma estrutura.

[2] SAS, ou “Statistical Analysis System”, é o nome de uma empresa pioneira em Business intelligence e de uma família de softwares gerenciadores de bancos de dados comercializados por ela. Fonte: Wikipédia.

[3] International Business Machines é uma empresa dos Estados Unidos voltada para a área de informática. A empresa é uma das poucas na área de Tecnologia da Informação com uma história contínua que remonta ao século XIX. Fonte: Wikipédia.