Publicações

Publicações

A Inteligência Artificial irá superar a mente humana? O mito do excepcionalismo da IA

Publicado em: 6 de setembro de 2023

Imagina que o Chat GPT 5 vai ter quase dez vezes o QI do Einstein. Se o Einstein conseguiu mudar e transformar totalmente a nossa humanidade. Então a gente está a uma atualização…

…Da Era de Ultron! [1][2]

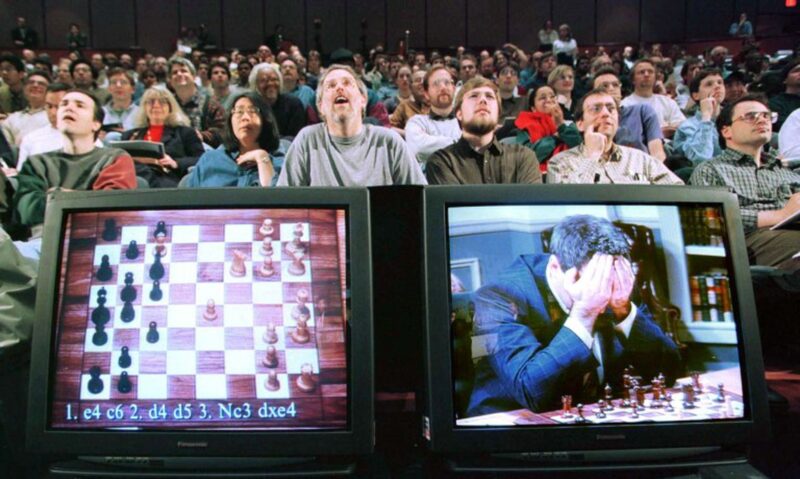

A quem não é especialista no assunto, embora distópica, a hipótese de que as máquinas podem superar a inteligência humana pode parecer verossímil. Se você já utilizou o Chat GPT, pode ter se impressionado com o quanto a conversa pode parecer realista. Computadores já são capazes de vencer campeões mundiais em jogos complexos como xadrez, gamão e pôquer. Feitos enormes já são possíveis, associados ao imenso volume de informações que esses sistemas são capazes de processar em poucos instantes.

Não é preciso ser leigo no assunto para se seduzir por essa possibilidade: mesmo especialistas, especialmente do campo da ciência da computação, têm feito afirmações semelhantes há décadas. O caso mais recente é o de Geoffrey Hinton, considerado o ‘padrinho da IA’ por ter criado o algoritmo que está por trás das redes neurais. Para construí-lo, o cientista buscou simular o funcionamento dos neurônios e ligações do cérebro humano. Ele declarou recentemente que as inteligências artificiais já seriam 1.000 vezes mais inteligentes do que humanos e que o risco de que assumissem o controle da sociedade é real. “O algoritmo que criamos nos anos 1980 é mais eficiente do que o cérebro. Os atuais grandes modelos de linguagem conseguem saber mais do que uma pessoa, com muito menos ligações.”.

Muitas dessas preocupações vão de encontro à ideia de singularidade tecnológica. O conceito descreve um momento em que a aceleração tecnológica se dá de tal forma que as máquinas e sistemas de IA superariam a compreensão e controle humanos, causando mudanças irreversíveis. O debate foi popularizado por Vernor Vinge em 1993, ao discutir um ponto iminente no futuro em que o rápido avanço poderia levar a mudanças drásticas na sociedade. Na esteira, Ray Kurzweil previa a hipótese em que a jornada rumo à singularidade se daria através de uma inteligência artificial de natureza super-humana, capaz de conceber ideias até então inimagináveis por humanos e desenvolver ferramentas mais sofisticadas. Isso poderia significar desde a superação de doenças até a busca pela imortalidade tecnológica.

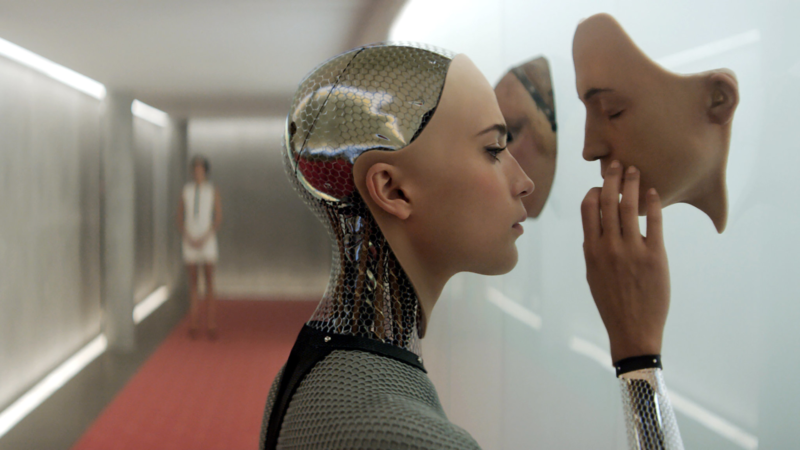

- Trecho do filme Ex_Machina: Instinto Artificial (2014), de Alex Garland.

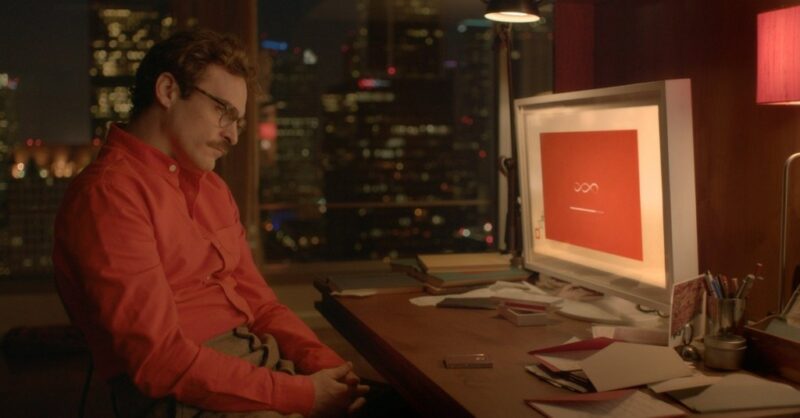

- Trecho do filme Her (2014), de Spike Jonze.

A singularidade é uma preocupação frequente na ficção científica. No clássico Neuromancer, de William Gibson (1884), os “policiais de Turing” teriam um papel especial em regular as inteligências artificiais capazes de melhorar seus próprios programas, de forma a garantir que nunca excedam um certo nível de inteligência. Toda a trama, aliás, está centrada nos esforços de uma dessas IAs para contornar esse controle. Filmes como Blade Runner (1984), Ex Machina (2015) e Her (2013), cada um apresenta, à sua maneira, visões em algum grau distópicas da inteligência artificial, centradas numa espécie de transcendência da máquina.

Características antropomórficas numa máquina?

Desde os primórdios do campo, a linguagem que vem emergindo em torno do Big Data e do machine learning sugere uma equação entre a inteligência humana e a da máquina ao evocar atividades que são humanas e biológicas. Antes de tudo, o termo “inteligência artificial”, cunhado por John McCarthy em 1956 para batizar o campo de estudos que discutia automação, não trazia consigo essa ambiguidade por mero descuido terminológico: as pesquisas desenvolvidas de fato carregavam a expectativa de que as máquinas pudessem exercer tarefas humanas, além de tarefas ligadas à cognição, como abstração e linguagem. No léxico do campo, as equivalências se seguem: redes “neurais”; “dados ‘alimentam’ um computador, que ‘digere’ as informações; máquinas podem”aprender ” e “pensar”; [3].

O termo machine learning, ou aprendizado de máquina, é um desses: sugere que o computador teria agência, e de alguma forma seria senciente, na medida em que “aprende” – termo normalmente aplicado a seres sencientes. Na prática, o “aprendizado” da máquina está mais próximo de uma metáfora: significa que a máquina pode melhorar seu desempenho em suas tarefas programadas, rotineiras e automatizadas. Quando uma máquina “aprende”, não significa que teria uma espécie de cérebro feito de metal; significa que se tornou mais precisa em realizar uma tarefa específica, de acordo com uma métrica específica definida por alguém. Não há conhecimento ou sabedoria ou agência adquiridos. Esse tipo de confusão linguística ajuda a borrar ainda mais as fronteiras entre humano e não-humano presentes no campo.

Da mesma forma, na detecção facial, um sistema de reconhecimento facial não “sabe”, como um humano faria, o que é ou não uma face. Em termos técnicos, diz respeito à “detecção de um conjunto de valores de pixel que geralmente se correlacionam bem com os rostos que estão presentes nos dados de treinamento coletados”. O mecanismo de validação envolvido não se baseia em ensinar a um computador o significado intrínseco do que seria uma face. O processo de antropomorfizar a linguagem associada à IA está longe de ser um descuido linguístico: é consonante com uma série de premissas, teorias e implementações baseadas no rompimento dessas fronteiras.

Como medir a inteligência de algo? Jogando xadrez?

Na ausência de uma compreensão clara de como o cérebro funciona e do que poderia ou não ser uma boa base para o conceito de inteligência, cientistas da computação introduzem vários proxies para inteligência, sendo o comportamento em jogos um dos principais. O emprego de jogos mais complexos tem sido um dos métodos preferidos para testar programas na história da pesquisa em IA desde 1950.

São diversos os exemplos: em 1979, o programa de computador BKG 9.8 derrotou o campeão mundial de gamão, Luigi Villa. Mas o caso mais conhecido é o confronto entre o campeão mundial de xadrez Garry Kasparov e o programa de computador Deep Blue, desenvolvido pela IBM. A primeira partida, em 1996, teve vitória de Kasparov. O programa então foi melhorado – se antes, podia analisar 100 milhões de jogadas por segundo, aumentou a capacidade para 250 milhões. No ano seguinte, ocorreu a famosa revanche, e a máquina venceu o humano. Mais recentemente, em 2011, o computador Watson, também da IBM, ganhou de humanos num jogo de perguntas e respostas, o Jeopardy. O jogo Go, jogado milenarmente na China, foi uma das últimas barreiras – seu campeão mundial foi derrotado em 2016 pelo computador AlphaGo. Mas o que isso significa?

“Temos quase 50 anos de competições humano/computador, mas isso significa que algum desses computador é inteligente? Não, não significa. Por dois motivos: a primeira é que xadrez não é um teste de inteligência; é o teste de uma habilidade particular, a habilidade de jogar xadrez. Se eu pudesse vencer um campeão de xadrez e ainda não ser capaz de te passar o sal na mesa quando me fosse pedido, eu seria considerado inteligente? O segundo motivo é que pensar que xadrez seria um teste de inteligência é baseado na falsa premissa cultural de que jogadores brilhantes de xadrez seriam mentes brilhantes, mais geniais do que as demais pessoas. Sim, muitas pessoas inteligentes podem ser excelentes em xadrez, mas xadrez, como qualquer outra habilidade singular, não denota inteligência.” [4]

O uso de jogos para avaliar o desempenho das máquinas moldou agendas de pesquisa, assim como implicitamente priorizou certos tipos de inteligências em detrimento de outras. No entanto, é preciso lembrar que diferente da vida cotidiana, jogos oferecem um mundo fechado, com parâmetros definidos e condições claras de vitória.

Afinal, do que é feita a inteligência humana?

A ideia de que sistemas não humanos (sejam computadores ou animais) seriam análogos à mente humana e que, com treinamento suficiente, ou recursos suficientes, uma inteligência como a nossa poderia ser criada do zero é uma mitologia particularmente forte no campo da IA. Desde a metade do século XX, a crença de que a inteligência humana poderia ser formalizada e reproduzida por máquinas é debatida por teóricos. Em 1950, Alan Turing, por exemplo, previa que ao final do século “o uso de palavras e opinião geral educada terão mudado tanto que será possível falar em máquinas pensantes sem esperar ser contrariado”.

Muitos desses posicionamentos se fundam na teoria computacional da mente (ou computationalism), que propõe que o pensamento é uma forma de computação, e sendo assim, cérebros complexos como o nosso são um sistema de processamento de informações. Uma vez que se assemelha a computadores digitais, o cérebro poderia ser reproduzido ou simulado por um computador altamente sofisticado. Atualmente, um exemplo disso é o Projeto Cérebro Humano, que tem todo o seu programa de pesquisa baseado na hipótese de que brevemente os computadores digitais serão capazes de simular o cérebro animal. Seu principal proponente, Henry Markham, declarou recentemente que “a consciência é somente o produto da troca massiva de informação entre um trilhão de células cerebrais… Eu não vejo por que nós não conseguiremos gerar uma mente consciente”.

O ponto cego em muitas dessas abordagens diz respeito ao conhecimento interdisciplinar necessário para compreender como a inteligência funciona para além do âmbito computacional, centrado no processamento de informações. O neurocientista Miguel Nicolelis destaca que o cérebro humano é repleto de funções superiores que não são computáveis: inteligência, intuição, criatividade, abstração matemática, empatia, altruísmo, medo da morte, senso estético, definições de beleza, criatividade, para citar alguns exemplos. Para ele, o cérebro tem três propriedades fundamentais: a maleabilidade para se adaptar e aprender; a habilidade de permitir que vários indivíduos sincronizem suas mentes em torno de uma tarefa, objetivo ou crença; e a incomparável capacidade de abstração. Apesar da eficiência do digital em transmitir informação por meio de sequências 0 e 1, o sistema analógico do cérebro dispõe de uma complexidade de processos inigualáveis. Em suma, as IAs podem até nos superar – e muito – em capacidade de calcular, mas são incapazes de atribuir qualquer significado a estes cálculos. Trata-se de uma diferença qualitativa, e não quantitativa.

Ademais, se considerarmos sob o ponto de vista sociológico, o problema de hipóteses como essas é que elas desconsideram as formas como humanos são corporificados, relacionais e situados dentro de ecologias mais amplas. É como se a inteligência existisse de forma independente, separada de forças sociais, culturais, históricas e políticas. É sempre importante lembrar de que o conceito de inteligência já causou inúmeros danos ao longo dos séculos, sendo usado para justificar relações de dominação, da escravidão à eugenia.

O mito do excepcionalismo da IA

Qualquer tecnologia suficientemente avançada é indistinguível da magia.

(Arthur Clarke, autor do conto de ficção científica The Sentinel, que inspirou o filme 2001: Uma Odisseia no Espaço)

Com muita frequência, as previsões exageradas sobre IA se alinham à ideia do excepcionalismo algorítmico – de que, porque sistemas de IA podem realizar proezas fantásticas de computação, eles devem ser mais inteligentes e objetivos do que seus criadores humanos, estes sempre suscetíveis a falhas. A premissa subjacente é a de que formalismos matemáticos poderiam nos ajudar a entender humanos e a sociedade com um nível preditivo de certeza. Há uma virada epistemológica em jogo: a complexidade do mundo poderia ser reduzida, com cada vez mais acurácia, à tradução realizada pelo aprendizado de máquina na medida em que separássemos o ruído informacional da “verdade”, expressa em dados.

Kate Crawford e Alex Campolo chamam isso de determinismo encantado: os sistemas de inteligência artificial seriam vistos como encantados, pertencentes a uma esfera além do mundo cognoscível, e ainda assim determinísticos, na medida em que descobrem padrões que podem ser aplicados com certeza preditiva à vida cotidiana. Isso confere à IA uma crença quase que teológica: ininterpretáveis até para os engenheiros que as criaram, dando aos sistemas uma aura de que seriam complexos demais para regular. A técnica do “obscurecimento por mistificação” é empregada com frequência nos setores públicos para defender a inevitabilidade de um fenômeno. E considerar algo inevitável é perigoso: implica considerar que não há alternativas, não há nada que possa ser feito a não ser aceitar. Nos é dito para focar na natureza inovativa do método ao invés do que é mais básico: seu propósito. Para os autores, o determinismo encantado obscurece o poder e cerceia discussões públicas informadas, escrutínio público ou mesmo a possibilidade de rejeição total.

O determinismo encantado tem duas faces complementares: o utopismo e distopismo técnico. O utopismo técnico vê as intervenções computacionais como soluções universais aplicáveis a quaisquer problemas. Já o distopismo técnico culpa os algoritmos por suas consequências negativas, como se fossem agentes independentes que não prestam contas a ninguém ou aos contextos que os moldam e nos quais operam. Tanto um quanto o outro são gêmeos metafísicos: tratam a inteligência das máquinas como algo singular ou superlativizado, que seria solução ou ruína para todos os problemas, numa visão ahistórica em que somente a tecnologia tem poder sobre as coisas.

Nem inteligente, nem artificial. Do que estamos falando então?

De acordo com o neurocientista Miguel Nicolelis, a inteligência artificial não é inteligente nem artificial. “Não é artificial porque é criada por nós, é natural. E não é inteligente porque a inteligência é uma propriedade emergente de organismos interagindo com o ambiente e com outros organismos, um produto do processo darwiniano de seleção natural. O algoritmo pode andar e fazer coisas, mas não é inteligente por definição.”.

Já numa perspectiva mais ampla, a socióloga Kate Crawford faz a mesma afirmação de que a IA não possui nenhum dos dois atributos, mas apontando para outros aspectos: ela reforça que esses sistemas são tanto corporificados como materiais, feitos de recursos naturais, combustível, trabalho humano, infraestrutura, logística, histórias e classificações. Não possuem autonomia ou racionalidade e não conseguem discernir qualquer coisa sem um treinamento computacional extenso e intensivo, com amplos conjuntos de dados e regras predefinidas. Ao depender de todos esses atributos para existir, tanto refletem como reproduzem relações sociais e compreensões do mundo.

Mesmo na comunidade da ciência da computação, o termo “inteligência artificial” já entrou e saiu de moda ao longo das décadas. Em geral, costuma-se dizer que é um guarda-chuva que abrange um conjunto de técnicas. Assim, o mais comum que tem sido utilizado pela literatura técnica é o uso de terminologias mais específicas, como machine learning, ou aprendizagem de máquina. De acordo com Kate Crawford, a nomenclatura da IA costuma ser resgatada em temporadas de submissão para financiamento, tendo um potencial publicitário maior, além de ser mais facilmente compreendido por não-especialistas. O que é importante observar, mais do que um conceito fechado, é que cada forma de definir inteligência artificial exerce um trabalho, delimitando como será entendido, medido, valorado e governado.

Em termos práticos, ainda que saibamos que a definição está longe de ser um consenso, Paz Canales destaca que ainda há um longo caminho para que o que tem sido implementado na América Latina possa ser efetivamente chamado de IA. Na maior parte dos casos, trata-se de desenvolvimentos tecnológicos modestos, que dizem respeito a processos de tomada de decisão automatizados, ou algoritmos que simplificam o processamento de grandes volumes de informação, mas cujos rótulos são adotados por governos por terem um apelo maior, associado à eficiência e modernidade. O mais importante, para a autora, é não perder de vista a perspectiva do interesse público na adoção dessas tecnologias, evitando cair no tecnosolucionismo.

Muitos desses sistemas são baseados em modelos que codificam estereótipos sobre as minorias e eliminam o contexto de onde vêm as informações, reforçando dinâmicas discriminatórias e espalhando desinformação. Enquanto isso, decisões automatizadas já estão sendo utilizadas no Brasil, por exemplo, para o acesso a políticas públicas como o Auxílio Emergencial e no Sistema Nacional do Emprego (SINE). Na maior parte das vezes, com poucos mecanismos de avaliação e prestação de contas. No momento, está em tramitação um projeto de lei que irá regulamentar a inteligência artificial no país, o PL 2338/2023, com potencial para atenuar ou aprofundar muitos desses impactos sobre a população brasileira.

Não é mágica: é estatística em larga escala [5]. O mais urgente a ser compreendido sobre inteligência artificial e seus riscos não diz respeito a uma hipotética dominação da humanidade por robôs ultra inteligentes ou qualquer outro cenário digno de ficção científica. É o impacto de tecnologias que já estão sendo implementadas neste momento sobre a população, especialmente a mais vulnerável, e cujos efeitos já podem ser sentidos. É questionar o sobre o que está sendo implementado, para quem está sendo implementado e a quem cabe decidir.

Notas

[1] Diálogo entre Felipe Castanhari e Cauê Moura em episódio do podcast Podpah transmitido em 27 de junho de 2023. Transcrição com trechos recortados. Versão integral disponível em: https://www.youtube.com/watch?v=9S5ls_QltgU

[2] No filme Os Vingadores: A Era de Ultron, o enredo está centrado em uma inteligência artificial que seria usada para o programa de defesa global de Tony Stark para garantir a paz, denominado Ultron. Porém, ao despertar, a IA conclui que para atingir o objetivo para o qual foi concebida deverá exterminar a humanidade.

[3] Tradução nossa. No original: “data are ‘fed’ to a computer and ‘digests’ information and machines ‘learn’ and ‘think’.”. Ver: p. 66 de ELISH e BOYD, 2018.

[4] Tradução nossa. Ver: NEVILLE-NEIL, 2017.

[5] Ver: CRAWFORD, 2021.

Referências

BROUSSARD, Meredith. Artificial Unintelligence: How Computers Missunderstand the World. London: MIT Press, 2018.

CAMPOLO, Alexander; CRAWFORD, Kate. Enchanted determinism: Power without responsibility in artificial intelligence. Engaging Science, Technology, and Society, 2020.

CANALES, Maria Paz. What do We Talk About When We Talk About AI? In America Latina in a Glimpse. Derechos Digitales. 2020.

CRAWFORD, Kate. Atlas of AI. New Haven and London: Yale University Press, 2021.

GANASCIA, Jean-Gabriel. Inteligência Artificial: Entre o Mito e a Realidade. In Correio da UNESCO, nº3, julho-setembro de 2018.

ELISH, M.C.; BOYD, Danah. Situating Methods in the magic of Big Data and AI. Pág. 66. Communication Monographs, 2018.

MEYRAN, Regis. Miguel Benasayag: São os humanos, não as máquinas, que criam significado. In Correio da UNESCO, nº3, julho-setembro de 2018.

NEVILLE-NEIL, George. 2016. The Chess Player Who Couldn’t Pass the Salt.Communications of the ACM, v. 60, n. 4, 2017.

NICOLELIS, Miguel; CICUREL, Ronald. O Cérebro Relativístico. Natal, Montreux, Durham, São Paulo: Kios Press, 2015.

Clarissa Mendes

Graduada em Relações Internacionais (FIR) e Ciências Sociais (UFPE), com intercâmbio na Facultad de Filosofia y Letras na Universidad de Valladolid (Espanha). Na UFPE, é mestra e doutoranda em Sociologia, além de integrante do Núcleo de Estudos e Pesquisas em Políticas de Segurança (NEPS). Atualmente, é pesquisadora nas áreas de Inteligência Artificial e Tecnologias de Realidade Virtual e Realidade Aumentada no IP.rec.